Connaissant la matrice de covariance d'erreur d'analyse, il est possible d'essayer de minimiser son erreur scalaire (\[ \mathrm{Tr}(\mathbf{A}) \]). Il doit donc exister un gain optimal \[ \mathbf{K}^*\] qui peut être obtenu en étudiant la variation de l'erreur scalaire d'analyse sous une variation du gain. Comme la trace est une fonction scalaire continue et différentiable des coefficients de \[ \mathbf{K} \], il est possible d'exprimer sa dérivé \[ d_{\mathbf{K}} \] au premier ordre :

\[ d_{\mathbf{K}}\left(\mathrm{Tr}(\mathbf{A})\right) = \mathrm{Tr}\left( -\mathbf{H}\mathbf{B}\mathbf{L}^T - \mathbf{L}\mathbf{B}\mathbf{H}^T + \mathbf{R}\mathbf{K}^T + \mathbf{K}\mathbf{R} \right) \]

\[ d_{\mathbf{K}}\left(\mathrm{Tr}(\mathbf{A})\right) = \mathrm{Tr}\left( \mathbf{R}\mathbf{K}^T -\mathbf{H}\mathbf{B}\mathbf{L}^T \right) +\mathrm{Tr}\left( \mathbf{K}\mathbf{R} - \mathbf{L}\mathbf{B}\mathbf{H}^T \right) \]

(013)

\[ d_{\mathbf{K}}\left(\mathrm{Tr}(\mathbf{A})\right) = 2\mathrm{Tr}\left( \mathbf{K}\mathbf{R} -\mathbf{L}\mathbf{B}\mathbf{H}^T \right) \]

L'équation (013) est obtenue en utilisant des propriétés de l'algèbre linéaire telles que la trace est linéaire \[ \mathrm{Tr}(\mathbf{B}+\alpha\mathbf{R})=\mathrm{Tr}(\mathbf{B})+\alpha\mathrm{Tr}(\mathbf{R}) \]), la trace de la transposée égale la trace (\[ \mathrm{Tr}(\mathbf{B}^T)=\mathrm{Tr}(\mathbf{B}) \]) et les matrices symétriques sont égales à leurs transposées (\[ \mathbf{B}^T=\mathbf{B} \]).

Pour obtenir le gain optimal \[ \mathbf{K}^*\], il faut que \[ d_{\mathbf{K}}\left(\mathrm{Tr}(\mathbf{A})\right)=0\]. L'équation (013) donne alors le résultat suivant :

\[ \mathbf{K}^*\mathbf{R} -\mathbf{L}\mathbf{B}\mathbf{H}^T = 0\],

\[ \mathbf{K}^*\mathbf{R} -(\mathbf{I}-\mathbf{K}^*\mathbf{H})\mathbf{B}\mathbf{H}^T = 0\],

(014)

\[ \mathbf{K}^*(\mathbf{R}+\mathbf{H}\mathbf{B}\mathbf{H}^T) = \mathbf{B}\mathbf{H}^t\].

A l'optimalité, on a donc un gain égale

(015)

\[ \mathbf{K}^*=\mathbf{B}\mathbf{H}^T(\mathbf{R}+\mathbf{H}\mathbf{B}\mathbf{H}^T)^{-1}\].

Avec ce gain optimal, il est alors possible d'estimer \[\mathbf{x}^a\] et \[\mathbf{A}\]. C'est une estimation BLUE (Best Linear Unbiased Estimation) car elle est linéaire (Eq. (006)), sans biais (Eq. (008)) et optimale (Eq. (014)).

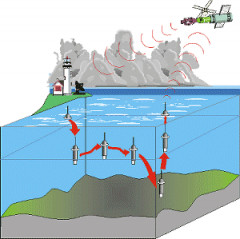

Chose promise, chose due. Alors, voici une vision générale de ce qui occupe les plus longues de mes heures : l'assimilation de données.

Chose promise, chose due. Alors, voici une vision générale de ce qui occupe les plus longues de mes heures : l'assimilation de données.